حوكمة الذكاء الاصطناعي: فرص وتحديات في الأمن السيبراني

مع ازدياد الاعتماد على تقنيات الذكاء الاصطناعي في مختلف المجالات، أصبحت حوكمة الذكاء الاصطناعي عاملاً رئيسيًا لضمان سلامة الأنظمة وحماية البيانات.

حيث تلعب هذه الحوكمة دورًا جوهريًا في تعزيز الثقة في التقنية الحديثة وضمان استخدامها بشكل مسؤول.

مر عامان تقريبًا منذ أن انتشر برنامج(ChatGPT) من شركة (OpenAI)، مما أثار اهتمامًا واسع النطاق بالذكاء الاصطناعي وأثار موجة من النمو التقني والاستثماري في هذا المجال.

لقد كانت التطورات في مجال الذكاء الاصطناعي منذ ذلك الحين مذهلة، مع زيادات هائلة في كل من البحث الأكاديمي والاستثمار.

الاستثمارات الأكاديمية والتقنية في الذكاء الاصطناعي:

تلقتNeurIPS) 2023) عددًا قياسيًا من الأوراق البحثية بلغ 5875 ورقة، مع قبول حوالي 26% فقط.

بينما راجعت ICML) 2023) ما يقرب من 6000 ورقة بحثية وقبلت حوالي 21%.

وبالإضافة لهذا الاهتمام الأكاديمي، تضاعف الاستثمار في مجال الذكاء الاصطناعي التوليدي وحده، ليصل إلى 25.2 مليار دولار، أي ما يقرب من ثمان أضعاف ما كان عليه في عام 2022، مع توجيه جزء كبير نحو بناء مراكز البيانات والكهرباء ووحدات معالجة الرسوم.

ومع ذلك، فإن السؤال حول كيفية تحقيق العائد من هذه الاستثمارات بشكل فعال لا يزال مفتوحًا.

دور الذكاء الاصطناعي في مواجهة التهديدات السيبرانية

في مجال الأمن السيبراني، أصبح الذكاء الاصطناعي ممكّنًا قويًا، حيث حقق تقدمًا كبيرًا في العديد من الأصعدة.

فعلى سبيل المثال، يعد اكتشاف هذه الاختلافات إحدى المجالات التي أثبتت فيها تقنيات تعلم الآلة والتعلم العميق فعاليتها العالية، مما يعزز القدرات على اكتشاف الأنماط غير العادية التي قد تشير إلى تهديدات إلكترونية.

كما يتم الاستفادة بشكل متزايد من نماذج اللغة الكبيرة (LLMs)، بما في ذلك تلك المشابهة لـ ChatGPT، في صياغة سيناريوهات مثل محاكاة التصيد الإلكتروني (Phishing)

وفي مجال الكشف عن الاحتيال، يوفر الذكاء الاصطناعي أدوات للكشف عن الأنشطة الاحتيالية ومنعها، في حين تعمل طرق المصادقة الذكية مثل (mPass ) على تحسين التحقق من الهوية والحد من مخاطر الوصول غير المصرح به.

وعلاوة على ذلك، تعتمد الأتمتة في مراكز عمليات الأمن (SOC) على الذكاء الاصطناعي لتبسيط الاستجابة وإدارة الحوادث، مما يجعل فرق الأمن أكثر كفاءة واستباقية.

التحديات والمخاطر المرتبطة بتطورات الذكاء الاصطناعي

تطور الذكاء الاصطناعي، يقدم أيضًا مخاطر جديدة للأمن السيبراني يجب معالجتها في وقت مبكر وإدارتها بعناية.

إن الحاجة الملحة لاعتبارات الأمن السيبراني ضرورية في مرحلة التصميم، كما يتضح لنا من الحوادث الأخيرة:

أعلنت (Hugging Face) أنها اكتشفت “وصولاً غير مصرح به” إلى منصة استضافة نموذج الذكاء التوليدي الخاصة بها حيث تم العثور على بعض الثغرات والأخطاء التي سمحت في بعض الحالات باستضافة كود يمكنه اختراق أجهزة المستخدمين.

تم العثور على ثغرات أخرى في أنظمة مرتبطة بـ LLMs مثل LangChain

مجالات أخرى مثل استخدام التزييف العميق لتوزيع المعلومات المضللة

يمكن أن تكون مجالات مثل أمن البنية التحتية هدفًا أيضًا

التطبيقات الدفاعية لتطورات الذكاء الاصطناعي في الأمن السيبراني

أما من الجانب الإيجابي، فلدى الذكاء الاصطناعي و LLMs أيضًا تطبيقات دفاعية للأمن السيبراني، مثل تحديد الثغرات الأمنية في الكود وتقديم إرشادات الإصلاح.

يكمل نهج “الذكاء الاصطناعي من أجل الأمن” الأساليب التقليدية ويساعد في الكشف عن التهديدات بسرعة.

حوكمة الذكاء الاصطناعي

على مدى السنوات الأخيرة، أحدث الذكاء الاصطناعي ثورة في مختلف القطاعات بفضل قدرته على التعامل مع البيانات بفعالية وسرعة.

ومع تطور هذه التقنيات برزت أهمية حوكمة الذكاء الاصطناعي، حيث أصبح من الضروري تطبيق سياسات وإجراءات تضمن استخدامها بشكل آمن وأخلاقي يحافظ على أمن المعلومات وسلامة المجتمع.

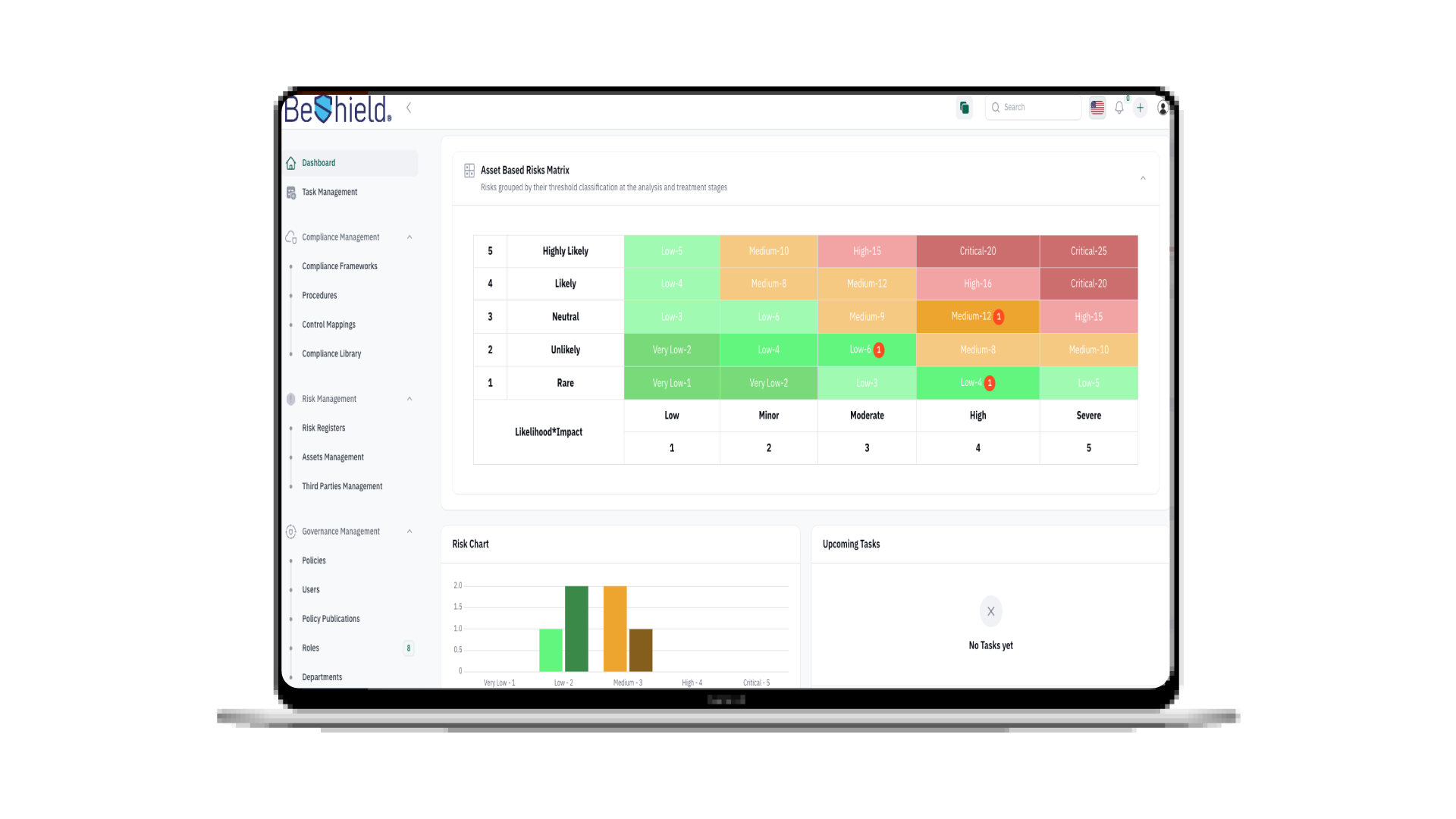

لتعزيز الاستخدام المسؤول للذكاء الاصطناعي، يجب على الشركات اعتماد إطار عمل قوي لحوكمة الذكاء الاصطناعي والأمن يتناول ما يلي:

خصوصية الذكاء الاصطناعي وحماية البيانات

تحتل حماية خصوصية البيانات موقعًا رئيسيًا ضمن سياسات حوكمة الذكاء الاصطناعي.

مع استخدام المزيد من البيانات لتدريب وضبط نماذج الذكاء الاصطناعي، يجب على المؤسسات الالتزام بلوائح الخصوصية مثل اللائحة العامة لحماية البيانات أو الأطر المحلية مثل NDMO، مما يضمن امتثال معالجة البيانات لمعايير الخصوصية.

يتضمن هذا تقليل جمع البيانات، وإخفاء هوية البيانات، وضمان موافقة المستخدم، وتمكين قابلية نقل البيانات.

أمان البنية الأساسية للذكاء الاصطناعي

تُعد نماذج الذكاء الاصطناعي والبنية الأساسية التي تعتمد عليها أهدافًا جذابة بشكل متزايد للهجمات الإلكترونية، ولذلك يجب دمج نقاط التشييك الأمنية في وقت مبكر من عملية التطوير بدلاً من ضبطها لاحقًا.

ويجب على الشركات تبني مبادئ “الأمن عند التصميم” لحماية أنظمة الذكاء الاصطناعي من الهجمات وتسريب البيانات.

الأخلاقيات والحواجز الواقية ضد الاستخدام الضار

من الضروري بناء حواجز أخلاقية لمنع الذكاء الاصطناعي من تسهيل النتائج الضارة، مثل إنشاء مقاطع فيديو مزيفة، أو نشر معلومات مضللة، أو دعم أنشطة ضارة أخرى.

يمكن أن يتم ذلك عن طريق:

وضع إرشادات حول الاستخدام المسؤول، ومراقبة المخرجات بانتظام بحثًا عن المحتوى الضار، وتنفيذ خوارزميات التحقق من التحيز لمنع العواقب غير المقصودة.

العدالة والتخفيف من التحيز

إن ضمان عدم قيام أنظمة الذكاء الاصطناعي بنشر أو تضخيم التحيزات المتعلقة بالعرق أو الجنس أو السمات الحساسة الأخرى أمر ضروري لحوكمة الذكاء الاصطناعي الأخلاقية.

يجب على الشركات تبني تقنيات للكشف عن التحيز والتخفيف منه في أثناء تدريب النموذج واختباره. تساعد مجموعات البيانات المتنوعة والمراقبة المستمرة للتأثير المتباين في خلق نتائج أكثر عدالة للذكاء الاصطناعي.

اعتبارات الاستدامة

إن استهلاك الطاقة المرتبط بتدريب ونشر نماذج الذكاء الاصطناعي الكبيرة له تأثيرات بيئية خطيرة؛ لذلك يجب على الشركات تبني ممارسات الاستدامة من خلال تحسين النماذج لكفاءة الطاقة، والنظر في مراكز البيانات الخضراء، والإبلاغ عن البصمة البيئية لمشاريع الذكاء الاصطناعي.

الخلاصة

مع إعادة تشكيل الذكاء الاصطناعي لكل من الفرص والمخاطر في تقنية المعلومات، فإن تبني موقف استباقي بشأن حوكمة الذكاء الاصطناعي سيكون ضروريًا لتعظيم الفوائد مع تقليل الأضرار المحتملة.

في خضم التطور السريع لتقنيات الذكاء الاصطناعي، يبرز أمن الذكاء الاصطناعي كعامل حاسم لضمان حماية الأنظمة الرقمية والحفاظ على سلامة البيانات.

تظل التحديات السيبرانية متزايدة، مما يستدعي تطوير استراتيجيات متقدمة ومستمرة لتعزيز الأمان. ومع كل فرصة جديدة يوفرها الذكاء الاصطناعي، يأتي التزام أكبر بتطبيق ممارسات أمان قوية تضمن لنا مستقبلًا رقميًا آمنًا ومستدامًا

شارك المقال:

الأكثر زيارة

نقلة نوعية في منصة التواصل المؤسسي مع (LinQ2)

نقلة نوعية في منصة التواصل المؤسسي مع (LinQ2) في بيئة الأعمال المتسارعة اليوم، يعد التواصل المؤسسي العمود الفقري للنجاح سواء كان الأمر يتعلق بالوصول إلى العملاء أو التنسيق مع الموظفين أو أتمتة الإشعارات، فإن وجود منصة رسائل فعالة أمر ضروري وهنا يبرز نظام (LinQ2) من سيريبرا كالحل الأمثل، حيث يقدم بوابة إشعارات متعددة القنوات مصممة خصيصاً للشركات من جميع الأحجام. لماذا تعد منصة التواصل المؤسسي أساسية لنمو الأعمال؟ تضمن منصة التواصل المؤسسي الفعالة قدرة الشركات على البقاء على اتصال مع عملائها وفرق العمل في الوقت الفعلي. غالبًا ما تؤدي أنظمة الاتصال الضعيفة إلى ضياع الفرص، انزعاج العملاء، وتأخيرات في العمليات ...

11th مارس 2025

التزييف العميق (Deepfake) في التصيد الإلكتروني: التحديات والحلول

في عصر التقنيات المتقدمة، أصبح التزييف العميق أحد أكبر التحديات التي تواجه الأمن السيبراني. تعتمد هذه التقنية على الذكاء الاصطناعي، وخاصة التعلم العميق، لإنشاء محتوى مزيف يبدو حقيقيًا بشكل يصعب اكتشافه. في هذا السياق، يُعتبر التزييف العميق أداة متعددة الاستخدامات تتراوح بين الترفيه والأمن السيبراني، إلا أن إساءة استخدامه يمكن أن تتحول إلى خطر كبير، خاصةً في مجال التصيد الإلكتروني. ما هو التزييف العميق (deepfake)؟ هو تقنية تعتمد على خوارزميات التعلم العميق لإنشاء مقاطع فيديو أو تسجيلات صوتية تبدو وكأنها حقيقية. يمكن استخدامها لتقليد أصوات وأشكال الأشخاص بدقة شديدة، مما يجعل المحتوى المزيف صعب التمييز عن الواقع. هذه ...

19th ديسمبر 2024

من التجسس إلى الحرب الشاملة: رحلة تطور الحروب السيبرانية عبر العصور

الحروب السيبرانية: من التجسس إلى الحرب رحلة عبر الزمن في ظل التطورات التكنولوجية الهائلة، توسعت حدود المعارك في العالم لتشمل الفضاء الإلكتروني، حيث ظهرت “الحروب السيبرانية” كتهديد يزداد خطورة على الأفراد والمؤسسات والدول. ومن ذو فترة، أصبح الخط الفاصل بين الحروب السيبرانية والتقليدية غير واضح، ولكن الأنشطة الأخيرة في المنطقة أوضحت أن الحرب السيبرانية أصبحت خطيرة ويمكن أن تؤدي إلى قتل الإنسان. في هذا المقال، سنغوص في رحلة عبر عالم الحروب السيبرانية، لفهم ماهي، وتاريخها، وتأثيراتها، وأنواعها، وتطورها، ونقدم بعض الحلول لمواجهة مخاطرها. لكن بدايةً لنتعرف على مصطلح الحروب بشكل عام ونلقي نظرة على أجياله الحروب وأجيال الحروب بشكل عام، ...

9th أكتوبر 2024

دليل الحفاظ على السلامة الرقمية للأطفال

حافظ على سلامة أطفالك في العالم الرقمي مرحبًا، جميعاً، الآباء والامهات وكل من هو مهتم برفاهية أطفالنا الصغار في هذا العالم الرقمي. سنتحدث اليوم عن موضوع بالغ الأهمية: ألا وهو السلامة الرقمية للأطفال. حيث تعدّ سلامة أطفالنا في العالم الرقمي مسؤولية تقع على عاتقنا جميعًا، كآباء ومعلمين ومجتمع. نعم، يمكن أن يكون الإنترنت مكانًا خطراً للغاية بالنسبة لأطفالنا الصغار خاصة مع انتشار عمليات التصيد الإلكتروني. لذا، دعونا نتعمق ونقدم لكم في هذا المقال الشامل، دليلًا شاملاً حول السلامة الرقمية للأطفال، التي يحتاج كل أب وأم الانتباه إليها: مخاطر الإنترنت للأطفال: تحول الإنترنت إلى جزء كبير من حياة أطفالنا. أعني، جديًا، ...

17th يوليو 2024

هل يمكن أن يتم اختراقك عن طريق Slack؟

هل يمكن أن يتم اختراقك عن طريق Slack؟ زاد استخدام منصات التعاون والتواصل مثل Microsoft Teams و Slack بشكل كبير، حيث أصبح يستخدمها ما يقرب 80% من الموظفين في المؤسسات. وقد صممت هذه المنصات لتكون مريحة وسهلة الإدارة للمحادثات اليومية للمؤسسات. ولكن ما يجعلها سهلة ومريحة هو أيضاً ما يجعلها عرضة للخطر وللهجمات السيبرانية، ففي عام 2021، تم اختراق 780 جيجابايت من شركة الألعاب المعروفة Electronic Arts (EA) عن طريق برنامج Slack! وفي نفس العام، تم استغلال ثغرة أمنية في برنامج Microsoft Teams لشن هجوم سيبراني واسع النطاق على العديد من المؤسسات والشركات في أنحاء العالم، مما أدى ...

12th يونيو 2024

نصائح للمحافظة على امنك السيبراني خلال السفر

وداعاً للقلق! رحلة آمنة في العالم الرقمي في ظل التطورات المتسارعة التي يشهدها العالم الرقمي، يزداد اعتمادنا على تقنيات الاتصال الحديثة خلال رحلاتنا. ومما لا شك فيه أن تجربة السفر دائماً ما تكون من أجمل التجارب وأكثرها سروراً، ولكنها قد تتسبب في مجموعة من المخاطر خاصة عندما يتعلق الأمر بالأمن السيبراني. فقد يتعرض المسافرون للتصيد الإلكتروني والاحتيال والتجسس على شبكات الواي فاي المفتوحة، وسرقة بياناتهم الخاصة مما قد يجعل رحلتهم مليئة بالقلق والتوتر. ومع تزايد انتشار التهديدات السيبرانية، يصبح من الضروري أن يتبع المسافرون بعض التعليمات لحماية أجهزتهم وبياناتهم أثناء السفر بدءاً من تأمين اتصالات ( Wi-Fi) وحتى ...

1st أبريل 2024

Push Authentication : عصر جديد في التحقق من الهوية متعدد العناصر

وداعاً لكلمات المرور و رموز التحقق! تعرف على تقنية الـ Push Authentication من السهل أن تتعرض كلمة المرور الخاصة بك إلى الاختراق من خلال هجمات التصيد الإلكتروني، حتى وإن كانت تتوافق مع معايير الأمن السيبراني لكلمات المرور القوية وحتى لو كانت صعبت التوقع لذلك لا بد لنا أن نتعرف على تقنية Push Authentication. قد يوصيك البعض بأنه يجب عليك استخدام تقنية المصادقة متعددة العوامل او كما تسمى بتقنية التحقق من الهوية متعدد العناصرMulti-Factor Authentication (MFA)) لزيادة الأمان الخاص بك. والتي تعرف على أنها، عملية تسجيل الدخول إلى حسابك من خلال خطوات متعددة. حيث تتطلب منك إدخال معلومات أكثر وليس كلمة ...

14th فبراير 2024

الفرق بين هجمات التصيد الاحتيالي

الفرق بين هجمات التصيد الاحتيالي يعد التصيد الاحتيالي من أخطر الهجمات الإلكترونية التي يستخدمها المجرمون لسرقة المعلومات الشخصية والمالية للأفراد والشركات. ومع استخدام الإنترنت والتقنية في حياتنا بشكل يومي، تزداد الهجمات التي تستهدف الأفراد والمؤسسات. تتضمن هجمات التصيد الاحتيالي استخدام الخدع والأساليب الاحتيالية لإيهام الأفراد بأنهم يتفاعلون مع جهة موثوقة وغير مشبوهة، مثل: البنوك، شركات البريد الإلكتروني، أو حتى مواقع التواصل الاجتماعي. فما هو الفرق بين هجمات التصيد الاحتيالي؟ وكيف يمكن للأفراد والمؤسسات حماية أنفسهم من هذه الهجمات؟ هذا ما سنتحدث عنه في هذا المقال. ماهي أشهر أنواع التصيد الاحتيالي؟ من أشهر أنواع التصيد الاحتيالية التالي: التصيد الاحتيالي من ...

17th يوليو 2023

مفهوم التصيد الصوتي

التصيد الصوتي: الخدعة الصوتية الخفية لا تقع في شبكتها في عصر التقنيات الرقمية، تتطور فيه أساليب الاحتيال بسرعة، ومن بين هذه الأساليب الخبيثة، يبرز التصيد الصوتي كأداة فعالة يستخدمها المحتالون لاستدراج الأفراد والتلاعب بهم عن طريق المكالمات الهاتفية. في هذا المقال الشامل، سنتعرف على معنى التصيد عبر الصوت، والمخاطر المرتبطة به، والطرق الفعالة لحماية نفسك من هذه الهجمات الخبيثة ما هو التصيد الصوتي؟ يشير إلى الممارسة الاحتيالية لاستخدام خدمات الهاتف لخداع الأفراد وتصيدهم لاستخراج المعلومات الشخصية والمالية منهم. غالبًا ما يتنكر المحتالون بأنهم منظمات موثوقة أو أشخاص ذوي مصداقية لكسب ثقة ضحاياهم، من خلال توظيف تقنيات الهندسة الاجتماعية ...

5th يوليو 2023